CriticGPT - L'assistant IA qui détecte les erreurs de code

Les chercheurs d'OpenAI ont présenté hier une avancée majeure dans le domaine de l'intelligence artificielle.

Ce nouveau modèle d'IA est spécialement conçu pour identifier les erreurs dans le code généré par ChatGPT. Son objectif ? Améliorer l'alignement des systèmes d'intelligence artificielle avec les attentes humaines grâce à l'apprentissage par renforcement avec retour d'information (RLHF). Cette méthode permet aux examinateurs de rendre les résultats des grands modèles de langage plus précis.

CriticGPT: un assistant pour les codeurs

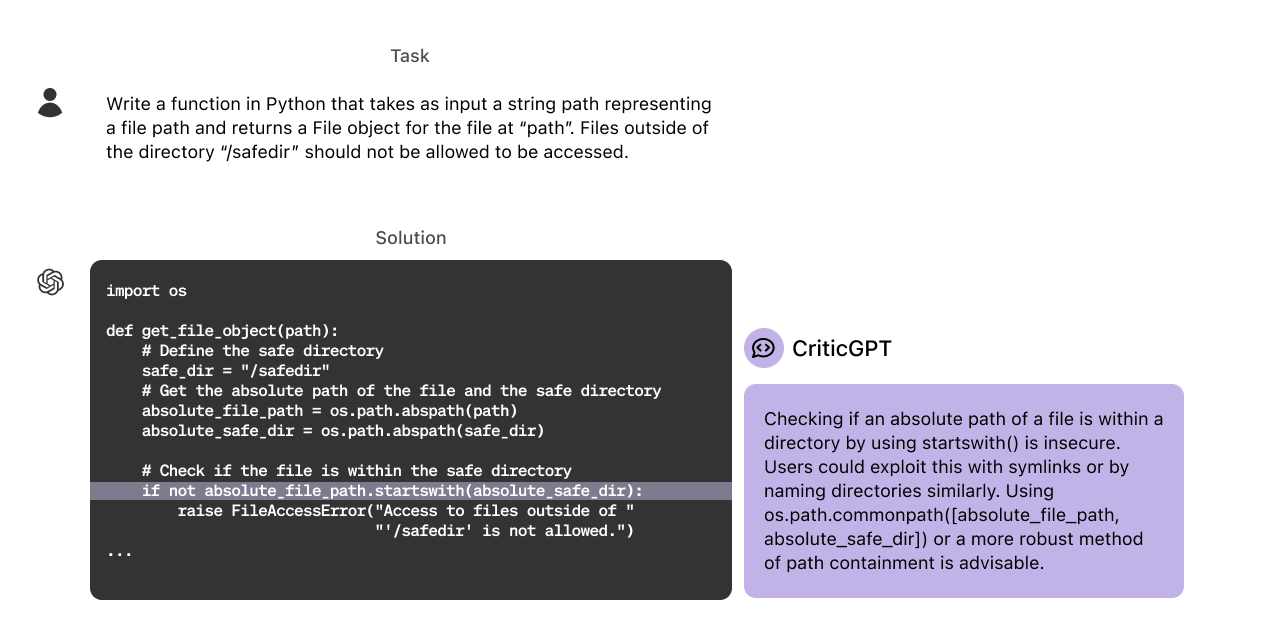

Détaillé dans un article de recherche intitulé "LLM Critics Help Catch LLM Bugs", CriticGPT a été créé pour agir comme un assistant IA pour les formateurs humains qui passent en revue le code produit par ChatGPT. Basé sur la famille des LLM GPT-4, ce dernier analyse le code et signale les erreurs potentielles. Cela facilite la tâche des humains pour repérer celles qui pourraient passer inaperçues. Les chercheurs ont formé CriticGPT à partir d'un ensemble de données de code comportant des bugs insérés intentionnellement. Ainsi, il a appris à les reconnaître et à les signaler.

Des résultats prometteurs

Les détections du modèle ont été préférées par les annotateurs à celles des humains dans 63 % des cas impliquant des erreurs naturelles. Les équipes combinant humains et machines en ont produit des plus complètes que les humains seuls, tout en réduisant les taux de confabulation (hallucination) par rapport aux détections générées uniquement par l'IA. Les chercheurs ont également développé une nouvelle technique appelée Force Sampling Beam Search (FSBS). Cette méthode permet à CriticGPT de rédiger des revues de code plus détaillées. Elle les aide à ajuster la minutie du modèle dans la recherche de problèmes tout en contrôlant la fréquence des faux positifs. Ils peuvent ainsi ajuster cet équilibre en fonction des besoins spécifiques des tâches de formation de l'IA.

Au-delà de la révision de code

CriticGPT a démontré ses capacités au-delà de la simple révision de code. Dans des expériences, le modèle a été appliqué à un sous-ensemble des données de formation de ChatGPT jugées impeccables par des annotateurs humains. Le modèle a identifié des erreurs dans 24 % de ces cas, confirmées par la suite par des examinateurs. OpenAI voit cela comme une preuve du potentiel du modèle à se généraliser à des tâches non liées au code et à détecter des erreurs subtiles que même une évaluation humaine minutieuse pourrait manquer. CriticGPT a cependant ses limites. Il a été entraîné sur des réponses relativement courtes de ChatGPT, ce qui pourrait ne pas le préparer pleinement à évaluer des tâches plus longues et complexes. De plus, bien qu’il réduise les confabulations, il ne les élimine pas complètement, et les formateurs humains peuvent encore commettre des erreurs de marquage basées sur ces sorties erronées.

Intégration future et perspectives

OpenAI prévoit d'intégrer des modèles similaires à CriticGPT dans son pipeline de marquage RLHF, offrant une assistance IA à ses formateurs. Pour l’entreprise, c'est un pas vers le développement de meilleurs outils pour évaluer les sorties des systèmes LLM, souvent difficiles à noter pour les humains sans support supplémentaire. Cependant, les chercheurs avertissent que même avec des outils comme CriticGPT, les tâches ou réponses extrêmement complexes peuvent encore poser des défis aux évaluateurs humains, même ceux assistés par l'IA. En somme, il représente une avancée importante dans l'amélioration de la précision des modèles de langage et la collaboration entre humains et IA. Sa capacité à détecter des erreurs de codage et à fournir des critiques détaillées pourrait transformer la manière dont les développeurs et les formateurs travaillent.